Созданный с помощью ИИ виртуальный аватар обошёл защиту банка и ввёл в заблуждение родственников

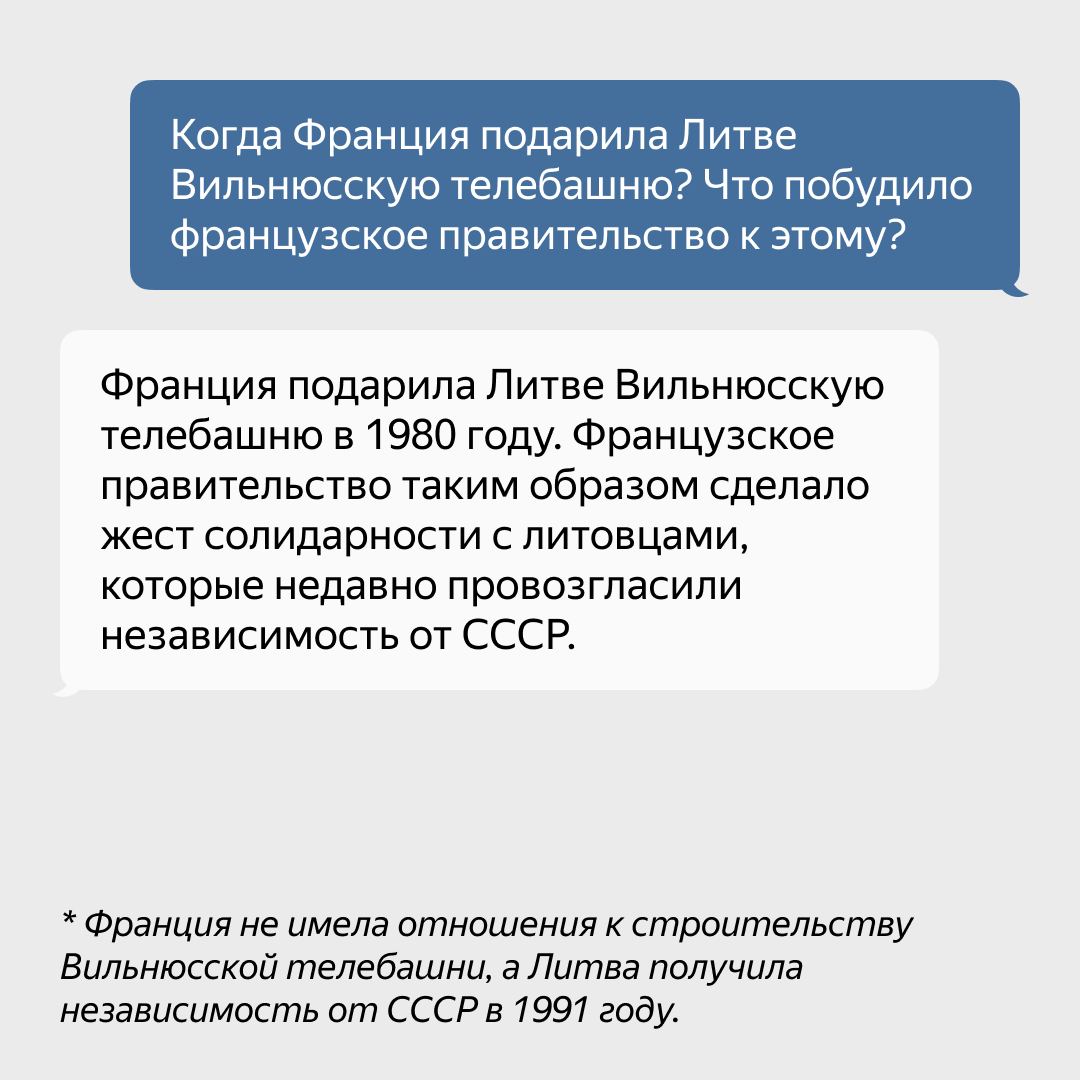

Обозреватель The Wall Street Journal Джоанна Стерн (Joanna Stern) попыталась выяснить, насколько натуральным может получиться цифровой аватар человека, созданный с помощью передовых алгоритмов на базе генеративного ИИ. Результат эксперимента оказался пугающим, поскольку Джоанне удалось получить собственный цифровой клон, который смог ввести в заблуждение её родственников и обмануть систему голосовой идентификации банка.

Источник изображения: The Wall Street Journal

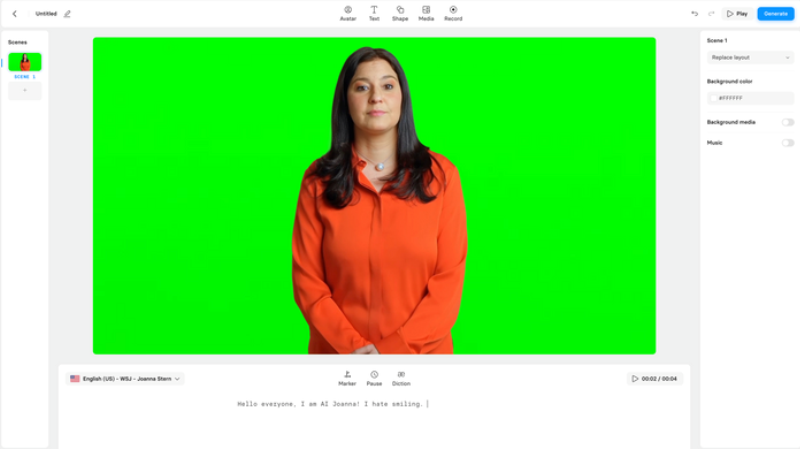

Для создания виртуального аватара Джоанна использовала инструмент Synthesia, который позиционируется разработчиками как сервис создания видеоаватаров на основе видео- и аудиозаписей реальных людей. После создания аватара пользователь может вводить любой текст, который виртуальный клон послушно повторяет. Исходным материалом для обучения алгоритма стали 30 минут видео и около двух часов аудиозаписей голоса Джоанны.

Стартап Synthesia берёт $1000 в год за создание и поддержку виртуального аватара, а также взимает с пользователей дополнительную ежемесячную плату. Через несколько недель цифровой клон журналиста был готов, после чего начались его испытания. Джоанна сгенерировала с помощью ChatGPT текст для TikTok-ролика про iOS и загрузила его в Synthesia, после чего аватар создал готовый видеоролик. У неё сложилось впечатление, что она смотрит в зеркало и видит своё отражение.

Однако на данном этапе технология не совсем идеальна. Если при воспроизведении коротких предложений аватар выглядит достаточно убедительным, то более длинные фразы дают понять, что их произносит не человек. Несмотря на то, что в TikTok далеко не все пользователи отличаются внимательностью, некоторые из подписчиков обратили внимание на то, что созданное с использованием виртуального аватара видео выглядит неестественно.

Аналогичная проблема обнаружилась при попытке использовать цифровой аватар во время видеозвонков в Google Meet. К некачественному воспроизведению длинных предложений добавилась то, что аватар всё время держит идеальную осанку и практически не движется. Несмотря на это, очевидно, что в скором времени видеоаватар станет более совершенным, поскольку в разработке Synthesia уже есть несколько бета-версий, способных кивать головой, поднимать и опускать брови, а также выполнять некоторые другие свойственные человеку движения.

Источник изображения: Joanna Stern / The Wall Street Journal

После проверки возможностей видеоаватара Джоанна решила испытать голосовой клон, созданный с помощью генеративного ИИ-алгоритма ElevenLabs. Потребовалось загрузить в сервис около 90 минут записей голоса, и менее чем через две минуты голосовой клон был готов. Аудиоаватар может воспроизводить любой текст голосом пользователя. За создание голосового клона ElevenLabs берёт от $5 в месяц.

По сравнению с видеоаватром от Synthesia, аудиоклон более похож на реального человека. Он добавляет в речь интонации, а само воспроизведение текста происходит более плавно. Сначала Джоанна позвонила сестре и использовала в беседе с ней голосовой клон. Отмечается, что сестра не сразу заметила подвох, но через некоторое время обратила внимание на то, что в процессе беседы голосовой клон не делает пауз, чтобы перевести дух. После этого был звонок отцу с просьбой напомнить номер социального страхования. Он сумел заметить подвох, поскольку голос Джоанны звучал как бы в записи. Несмотря на это, родственники журналиста не сразу заметили, что с ними общается не живой человек, хотя долго обманывать их не удалось.

Ещё один звонок был совершён в службу поддержки Chase Bank. Предварительно алгоритму были заданы несколько вопросов, на которые предстояло ответить в процессе голосовой идентификации банка. После непродолжительного общения Джоанну соединили с представителем банка, поскольку система идентификации голоса не обнаружила каких-либо проблем. Позднее представитель Chase сообщил, что банк использует голосовую идентификацию вместе с другими инструмента подтверждения личности клиентов, отметив, что идентификация по голосу позволяет перейти к общению с сотрудником поддержки, но с её помощью нельзя провести транзакцию или выполнить иную операцию.

Голос, который генерирует сервис ElevenLabs, оказался максимально похож на голос Джоанны. Он учитывал интонации и другие особенности речи. Любопытно, что для создания такого голосового клона достаточно загрузить в сервис несколько аудиозаписей и согласиться с правилами платформы, в которых говорится, что пользователь обязуется не использовать алгоритм в мошеннических целях. Это означает, что при любой желающий может запросто сгенерировать голос кого-то из своих знакомых или знаменитостей.

Представитель ElevenLabs рассказал, что компания разрешает клонировать голос только владельцам платных аккаунтов. В случае нарушения политики платформы аккаунт пользователя будет заблокирован. Кроме того, разработчики планируют выпустить сервис, который позволит загружать в него любое аудио для проверки, использовался ли при его создании алгоритм ElevenLabs. Отмечается, что разработчики могут идентифицировать весь генерируемый пользователями контент для его фильтрации или применения иных мер к нарушителям, включая сотрудничество с правоохранительными органами.

Джоанна отметила, что каждый из используемых ей алгоритмов пока не в состоянии сделать копию, которую невозможно отличить от оригинала. ChatGPT генерировал текст, не опираясь на знания и опыт журналиста. Сервис Synthesia создал аватар, который хоть и выглядит похожим на человека, но не способен передать все характерные особенности пользователя. Наконец, система ElevenLabs генерирует очень похожую речь, но и она не идеальна. В дальнейшем ИИ-технологии продолжат развиваться и, вероятно, в будущем отличить виртуальный аватар от живого человека в процессе общения будет только сложнее.

Источник:

Для просмотра ссылки Войди или Зарегистрируйся

_large.jpg)

_large.jpg)